Answer Questions with Right Image Regions: A Visual Attention Regularization Approach

之前模型存在的问题

- 尽管现有的 VQA 模型已经从视觉注意力中受益很多,但一个紧迫的问题在于缺乏视觉基础的指导。 这通常会导致视觉注意机制关注与正确答案不太相关的图像区域。

- 为了解决注意力机制关注的图像区域不正确的问题,看似简单的解决方案是将视觉注意力权重与明确的人类注意力保持一致。 然而,收集此类数据既昂贵又困难,从而限制了这种方法的实用性。

- 之前的Grad-CAM基于梯度的权重较大的图像区域与答案预测不密切相关。

作者贡献

- 提出了一种新的视觉注意规则化方法,该方法能够指导模型基于正确的图像区域正确回答问题。所提出的规则化方法是模型无关的,不需要人的注意监督,并且可以融入到大多数基于视觉注意的VQA模型中,如UpDn和LMH。

- 研究了VQA中普遍存在的视觉注意的忠实性。结果表明,视觉注意比Grad-CAM方法更能忠实于模型决策。

- 大量实验表明,该方法能同时提高视觉问答的精度和主干模型性能。作为副产品,通过将我们的正则化方法引入到一个强模型LMH中,我们可以在VQA-cpv2数据集上获得最新的性能。

视觉注意忠实性

视觉注意的忠实性所指的是:模型分配注意力权重较高的部分图像区域,对模型最终预测起到最大的作用,这称为高忠实性,而低忠实性则是,模型分配高的注意力权重的图像区域部分对答案的预测影响不大。

作者通过在基线模型UpDn上分别对Visual Attention和Grad-CAM两种方法在图像区域对模型性能变化和预测精度变化两方面进行了实验。

性能变化

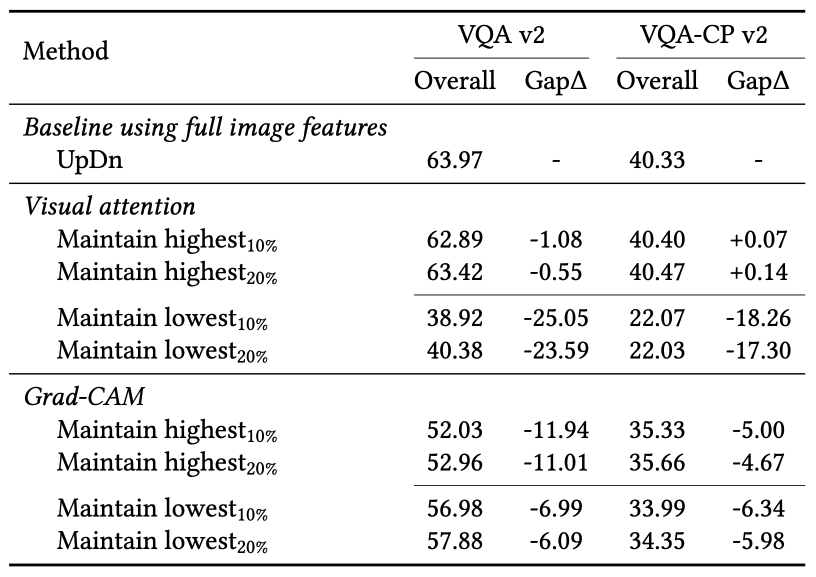

作者通过分别使用注意力权重最高10%和20%的图像区域来预测答案,使用注意力权重最低的10%和20%的图像区域来预测答案,如下表所示基于Visual Attention的模型在使用注意力权重最高的那部分图像区域来预测答案时,已经能表现出很好的性能,而使用注意力权重最低的那部分图像区域来预测答案时,性能相比基线模型而言下降了20%多的准确率,说明了基于Visual Attention的模型具有高忠实性。而基于Grad-CAM的模型无论是使用注意力权重高的图像区域还是注意力权重低的图像区域,都表现出了差不多的效果,这违背了注意力的忠实性。

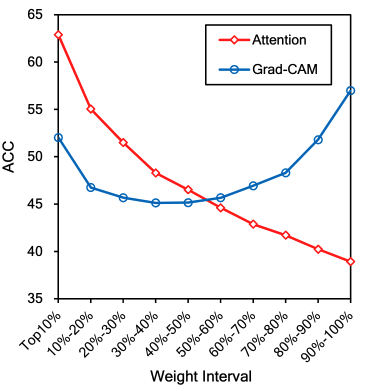

作者还制作了保留每个注意力权重区间的图像特征时,模型的性能变化如下图所示。

精确度变化

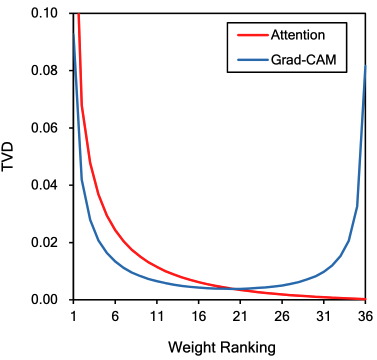

作者通过Total Variation Distance(TVD)来计算去除不同注意力权重排行的图像区域,答案预测的准确度.

[TVD(p_1,p_2)=frac{1}{2}sum_i|p_{1i}-p_{2i}|

]

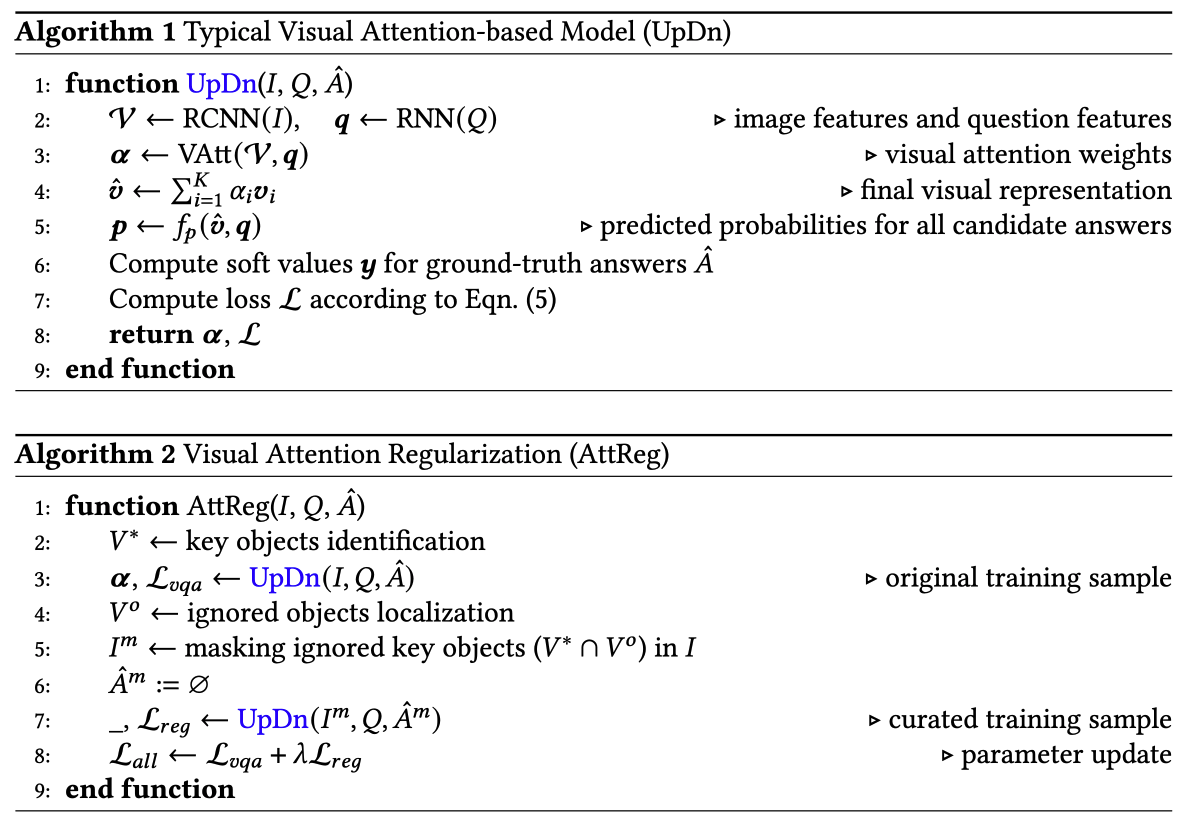

模型

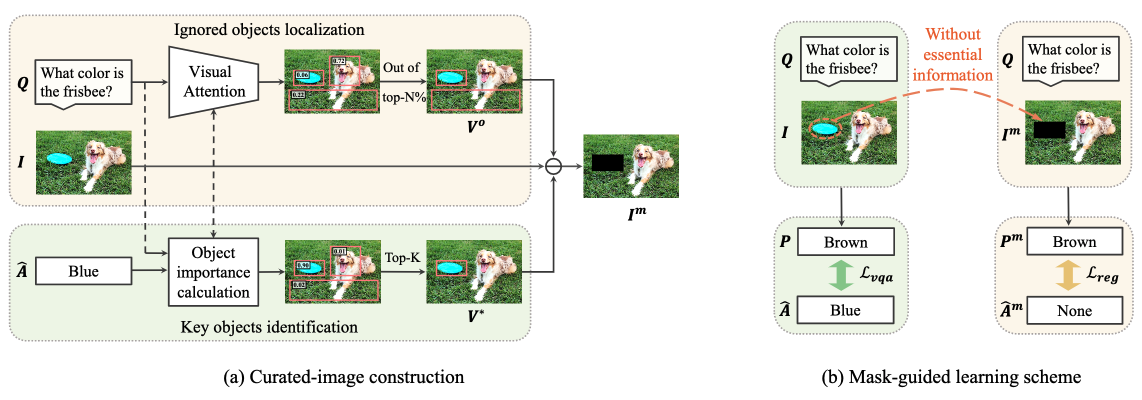

- 使用spaCy POS tagger为QA中的每个单词指定POS标记并提取名词。

- 计算对象类别的Glove embedding和提取的名词之间的余弦相似度。

- 提取相似度最高的M个目标作为关键对象(V^*)

- 在主干模型中通过注意力权重选出非最高权重的20%个图像区域(因为之前的性能变化实验证明了,仅使用20%最高注意力权重的图像区域的模型性能与使用全部图像区域的模型性能接近一样,因此非20%之外的图像区域为预测答案忽略(不需要)的图像区域。记为(V^0)

- 通过(V^*)和(V^0)的交集得到图像区域,此图像区域为预测答案关键的区域却在主干网络中被忽略的区域。

- 将关键却被忽略的区域在图像中进行遮掩,生成新的图像(I_m)。

- 将新的图像(I_m)放到和主干模型一样的模型中进行训练,让其的训练结果为空集(由于关键区域却被忽略的区域被遮掩,应当无法正确回答问题)

- 最终将主干模型的损失(L_{vqa})和新图像模型的损失(L_{reg})加权相加得到最后的损失(新图像模型在测试阶段不参与正向传播)。

[L_{all}=L_{vqa}+lambda L_{reg}

]

内容来源于网络如有侵权请私信删除

文章来源: 博客园

- 还没有人评论,欢迎说说您的想法!

客服

客服