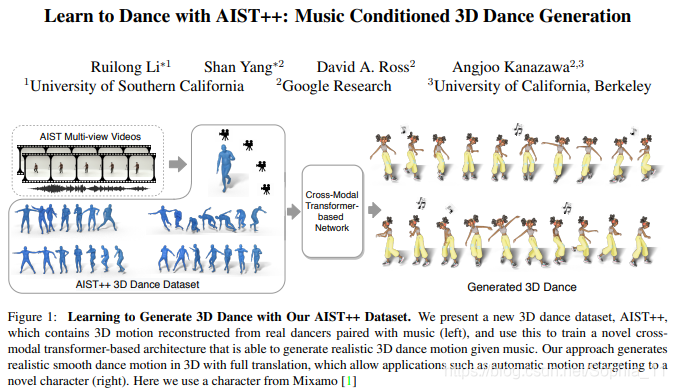

论文:Learn to Dance with AIST++: Music Conditioned 3D Dance Generation

数据集:https://google.github.io/aistplusplus_dataset/

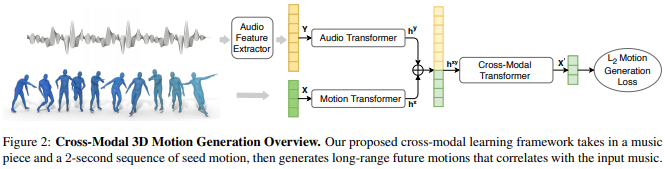

提出了一个基于Transformer的学习框架,用于基于音乐的3D舞蹈生成。设计了一个全新的网络框架,并验证得出获得高质量结果的关键。其中组件之一是深度跨模transformer,可以很好地学习音乐和舞蹈运动之间的相关性,并且具有 future-N 机制的全注意力在产生长距离 non-freezing 运动中至关重要。

AIST++ 数据集

我们提出了一个名为AIST++的成对3D运动和音乐的新数据集,我们从AIST多视点舞蹈视频中重建该数据集。AIST++是一个大型的3D人体舞蹈动作数据集,包含各种各样的3D动作搭配音乐。

AIST++提供了 10.1M 张图像的 3D 人体关键点标注和相机参数,涵盖 9 个视角的 30 个不同主体。以此成为现有的最大、最丰富的三维人体关键点标注数据集。

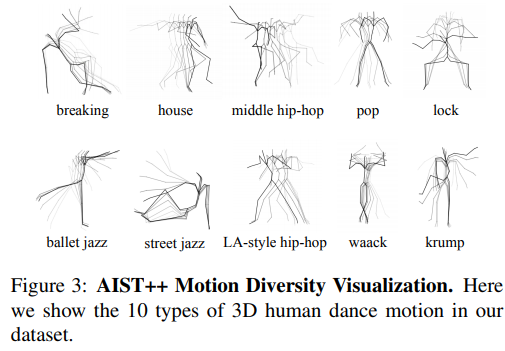

AIST++包含了 1408 个三维人体舞蹈运动序列,以 joint rotations 和 root trajectories 一起的形式表示。舞蹈动作平均分布在 10 个舞蹈流派和数百个编排中。动作持续时间从7.4秒到48.0秒不等。所有的舞蹈动作都有相应的音乐。

AIST++与其他数据集的比较,在长度方面,我们的AIST++数据集排名第三。在动作方面,我们的AIST++数据集有10种不同类型的舞蹈动作伴随音乐。Human3.6M第二大数据集[36],只有简单的行走,坐下等动作。

AIST++数据集10种3D人体舞蹈动作。

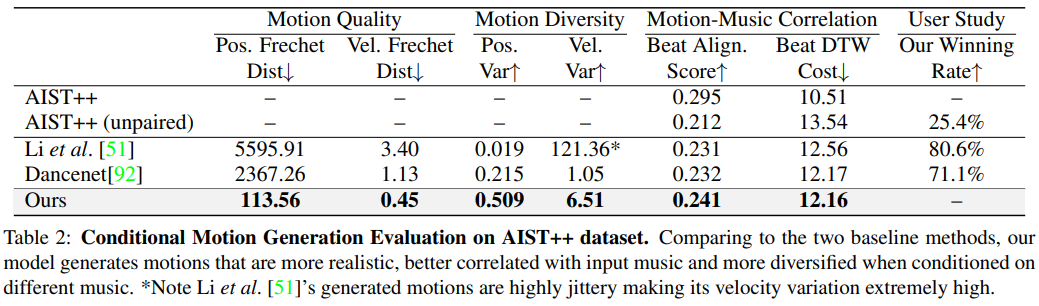

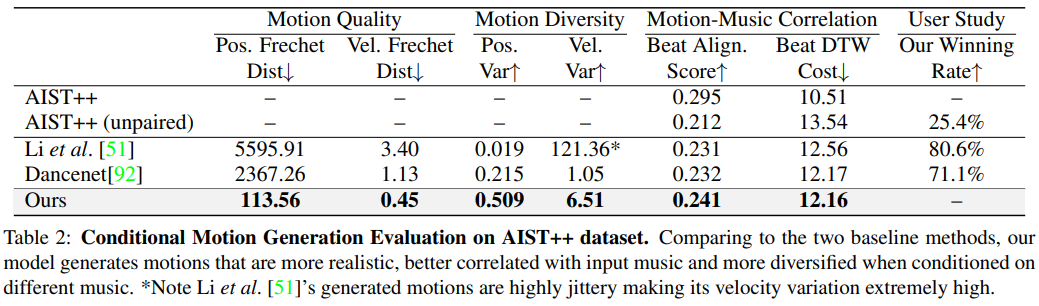

结果:与两种基线方法相比,我们的模型产生的运动更真实,与输入音乐的相关性更好,并在不同的音乐条件下更多样化。*注意Li等人[51产生的运动是高度紧张的,使其速度变化非常高。

仅作分享,不代表本号立场,侵权联系删除

文章来源: 博客园

- 还没有人评论,欢迎说说您的想法!

客服

客服